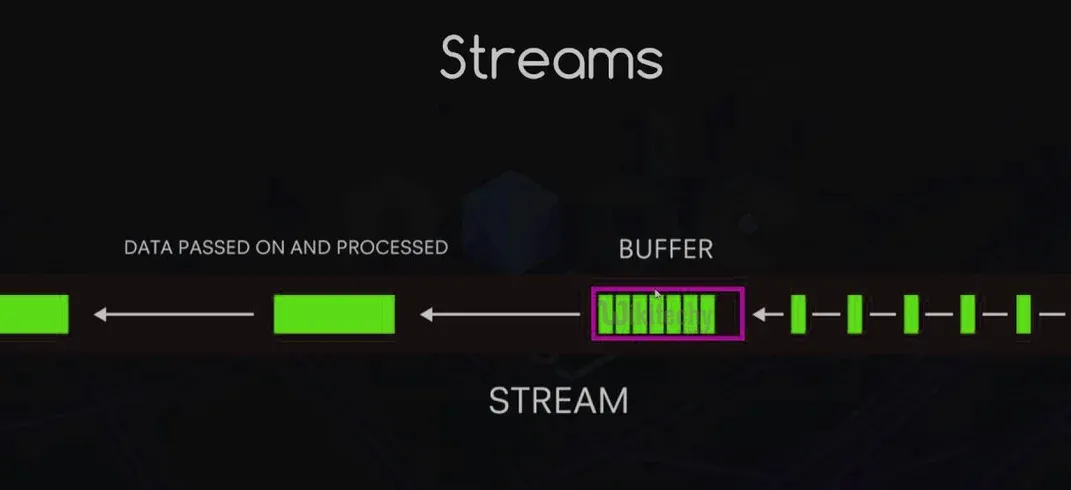

Les flux vous permettent de lire ou d'écrire des données par morceaux, sans avoir besoin de charger l'ensemble du jeu de données en mémoire. C'est crucial lorsque vous traitez de grandes quantités de données ou des informations en temps réel.

Mais pourquoi cela devrait-il vous intéresser ? Imaginez que vous construisez le prochain Netflix. Vous voulez que les utilisateurs commencent à regarder des vidéos instantanément, sans attendre que le fichier entier soit téléchargé. C'est là que les flux sont utiles. Ils vous permettent de traiter les données en petits morceaux, rendant votre application plus efficace et réactive.

Types de Flux : Choisissez Votre Combattant

Node.js propose quatre types de flux, chacun avec sa propre superpuissance :

- Readable : Pour lire des données. Pensez-y comme les yeux de votre application.

- Writable : Pour écrire des données. C'est le stylo de votre application.

- Duplex : Peut à la fois lire et écrire. C'est comme avoir des yeux et un stylo en même temps.

- Transform : Un type spécial de flux Duplex qui peut modifier les données pendant leur transfert. Pensez-y comme le cerveau de votre application, traitant les informations à la volée.

Comment Fonctionnent les Flux : Les Bases du Flux de Données

Imaginez un tapis roulant dans une usine. Les morceaux de données se déplacent le long de ce tapis, étant traités un par un. C'est essentiellement ainsi que fonctionnent les flux. Ils émettent des événements au fur et à mesure que les données les traversent, vous permettant de vous connecter à différentes parties du processus.

Voici un aperçu rapide des principaux événements :

data: Émis lorsqu'il y a des données disponibles à lire.end: Indique que toutes les données ont été lues.error: Houston, nous avons un problème !finish: Toutes les données ont été transférées au système sous-jacent.

Avantages de l'Utilisation des Flux : Pourquoi Vous Devriez Monter à Bord

Utiliser des flux n'est pas seulement une question de style (même si cela vous rend plutôt cool). Voici quelques bonnes raisons de les utiliser :

- Efficacité Mémoire : Traitez de grandes quantités de données sans consommer toute votre RAM.

- Efficacité Temporelle : Commencez à traiter les données immédiatement, sans attendre qu'elles soient toutes chargées.

- Composabilité : Reliez facilement les flux ensemble pour créer des pipelines de données puissants.

- Gestion Intégrée de la Contre-pression : Gérez automatiquement la vitesse du flux de données pour éviter de surcharger la destination.

Implémentation des Flux Readable et Writable : À Vos Claviers !

Passons à la pratique avec un peu de code. D'abord, créons un flux readable simple :

const { Readable } = require('stream');

class CounterStream extends Readable {

constructor(max) {

super();

this.max = max;

this.index = 1;

}

_read() {

const i = this.index++;

if (i > this.max) {

this.push(null);

} else {

const str = String(i);

const buf = Buffer.from(str, 'ascii');

this.push(buf);

}

}

}

const counter = new CounterStream(5);

counter.on('data', (chunk) => console.log(chunk.toString()));

counter.on('end', () => console.log('Finished counting!'));

Ce flux readable comptera de 1 à 5. Maintenant, créons un flux writable qui doublera nos nombres :

const { Writable } = require('stream');

class DoubleStream extends Writable {

_write(chunk, encoding, callback) {

console.log(Number(chunk.toString()) * 2);

callback();

}

}

const doubler = new DoubleStream();

counter.pipe(doubler);

Lancez ceci, et vous verrez les nombres 2, 4, 6, 8, 10 s'afficher. Magique !

Travailler avec les Flux Duplex et Transform : Une Rue à Double Sens

Les flux duplex sont comme une conversation téléphonique - les données peuvent circuler dans les deux sens. Voici un exemple simple :

const { Duplex } = require('stream');

class DuplexStream extends Duplex {

constructor(options) {

super(options);

this.data = ['a', 'b', 'c', 'd'];

}

_read(size) {

if (this.data.length) {

this.push(this.data.shift());

} else {

this.push(null);

}

}

_write(chunk, encoding, callback) {

console.log(chunk.toString().toUpperCase());

callback();

}

}

const duplex = new DuplexStream();

duplex.on('data', (chunk) => console.log('Read:', chunk.toString()));

duplex.write('1');

duplex.write('2');

duplex.write('3');

Les flux transform sont comme les flux duplex avec un processeur intégré. En voici un qui convertit les minuscules en majuscules :

const { Transform } = require('stream');

class UppercaseTransform extends Transform {

_transform(chunk, encoding, callback) {

this.push(chunk.toString().toUpperCase());

callback();

}

}

const upperCaser = new UppercaseTransform();

process.stdin.pipe(upperCaser).pipe(process.stdout);

Essayez de lancer ceci et de taper du texte en minuscules. Regardez-le se transformer magiquement en majuscules !

Gérer les Événements de Flux : Attraper Toute l'Action

Les flux émettent divers événements que vous pouvez écouter et gérer. Voici un aperçu rapide :

const fs = require('fs');

const readStream = fs.createReadStream('hugefile.txt');

readStream.on('data', (chunk) => {

console.log(`Received ${chunk.length} bytes of data.`);

});

readStream.on('end', () => {

console.log('Finished reading the file.');

});

readStream.on('error', (err) => {

console.error('Oh no, something went wrong!', err);

});

readStream.on('close', () => {

console.log('Stream has been closed.');

});

Pipelines de Flux : Construisez Votre Autoroute de Données

Les pipelines facilitent la chaîne des flux ensemble. C'est comme construire une machine de Rube Goldberg, mais pour les données ! Voici un exemple :

const { pipeline } = require('stream');

const fs = require('fs');

const zlib = require('zlib');

pipeline(

fs.createReadStream('input.txt'),

zlib.createGzip(),

fs.createWriteStream('input.txt.gz'),

(err) => {

if (err) {

console.error('Pipeline failed', err);

} else {

console.log('Pipeline succeeded');

}

}

);

Ce pipeline lit un fichier, le compresse et écrit les données compressées dans un nouveau fichier. Tout cela en une seule opération fluide !

Mise en Mémoire Tampon vs. Streaming : Le Duel

Imaginez que vous êtes à un buffet à volonté. La mise en mémoire tampon, c'est comme remplir toute votre assiette avant de manger, tandis que le streaming, c'est prendre une bouchée à la fois. Voici quand utiliser chacun :

- Utilisez la Mise en Mémoire Tampon Quand :

- Le jeu de données est petit

- Vous avez besoin d'un accès aléatoire aux données

- Vous effectuez des opérations nécessitant l'ensemble du jeu de données

- Utilisez le Streaming Quand :

- Vous traitez de grands jeux de données

- Vous traitez des données en temps réel

- Vous construisez des applications évolutives et économes en mémoire

Gérer la Contre-pression : Ne Faites Pas Exploser Vos Tuyaux !

La contre-pression se produit lorsque les données arrivent plus vite qu'elles ne peuvent être traitées. C'est comme essayer de verser un gallon d'eau dans un verre à pinte - ça devient désordonné. Les flux Node.js ont une gestion intégrée de la contre-pression, mais vous pouvez également la gérer manuellement :

const writable = getWritableStreamSomehow();

const readable = getReadableStreamSomehow();

readable.on('data', (chunk) => {

if (!writable.write(chunk)) {

readable.pause();

}

});

writable.on('drain', () => {

readable.resume();

});

Ce code met en pause le flux readable lorsque le tampon du flux writable est plein, et le reprend lorsque le tampon est vidé.

Applications Réelles : Les Flux en Action

Les flux ne sont pas seulement un tour de passe-passe. Ils sont utilisés dans des applications réelles tout le temps. Voici quelques exemples :

- Traitement de Fichiers : Lecture et écriture de grands fichiers journaux

- Streaming de Médias : Diffusion de contenu vidéo et audio

- Import/Export de Données : Traitement de grands fichiers CSV

- Traitement de Données en Temps Réel : Analyse des flux de médias sociaux

Optimisation des Performances : Boostez Vos Flux

Vous voulez rendre vos flux encore plus rapides ? Voici quelques conseils :

- Utilisez

Bufferau lieu de chaînes pour les données binaires - Augmentez le

highWaterMarkpour un débit plus rapide (mais attention à l'utilisation de la mémoire) - Utilisez

Cork()etuncork()pour regrouper les écritures - Implémentez un

_writev()personnalisé pour des écritures groupées plus efficaces

Débogage et Gestion des Erreurs : Quand les Flux Déraillent

Les flux peuvent être difficiles à déboguer. Voici quelques stratégies :

- Utilisez le module

debugpour enregistrer les événements de flux - Gérez toujours l'événement

'error' - Utilisez

stream.finished()pour détecter quand un flux est terminé ou a rencontré une erreur

const { finished } = require('stream');

const fs = require('fs');

const rs = fs.createReadStream('file.txt');

finished(rs, (err) => {

if (err) {

console.error('Stream failed', err);

} else {

console.log('Stream is done reading');

}

});

rs.resume(); // vide le flux

Outils et Bibliothèques : Boostez Vos Flux

Il existe de nombreuses bibliothèques pour faciliter le travail avec les flux. En voici quelques-unes qui valent le détour :

- through2 : Construction simplifiée de flux

- concat-stream : Flux writable qui concatène des chaînes ou des données binaires

- get-stream : Obtenez un flux sous forme de chaîne, de tampon ou de tableau

- into-stream : Convertissez un tampon/chaîne/tableau/objet en flux

Conclusion : La Puissance du Flux

Les flux dans Node.js sont comme une arme secrète dans votre boîte à outils de développeur. Ils vous permettent de traiter les données efficacement, de gérer de grands ensembles de données avec facilité et de construire des applications évolutives. En maîtrisant les flux, vous n'apprenez pas seulement une fonctionnalité de Node.js - vous adoptez un puissant paradigme pour le traitement des données.

Rappelez-vous, avec un grand pouvoir vient une grande responsabilité. Utilisez les flux judicieusement, et que vos données coulent toujours en douceur !

"Je stream, tu streams, nous streamons tous pour... un traitement efficace des données !" - Développeur Node.js Anonyme

Maintenant, allez de l'avant et streamez toutes les choses ! 🌊💻