TL;DR : Rust + Async = File d'attente de tâches surboostée

Le runtime asynchrone de Rust, c'est comme donner un coup de fouet à votre file d'attente de tâches avec un mélange d'espresso et de carburant de fusée. Il permet l'exécution concurrente des tâches sans la surcharge des threads au niveau du système d'exploitation, ce qui le rend parfait pour les opérations dépendantes des entrées/sorties, comme la gestion d'une file d'attente de tâches. Plongeons dans la manière dont nous pouvons exploiter cela pour créer un backend qui fera voler vos tâches plus vite qu'un guépard sous caféine.

Les Fondations : Tokio, Futures et Canaux

Avant de commencer à construire notre file d'attente de tâches haute performance, familiarisons-nous avec les acteurs clés :

- Tokio : Le couteau suisse... enfin, le runtime asynchrone polyvalent pour Rust

- Futures : Représentations des calculs asynchrones

- Canaux : Tuyaux de communication entre différentes parties de votre système asynchrone

Ces composants fonctionnent ensemble comme une machine bien huilée, nous permettant de construire une file d'attente de tâches capable de gérer un débit impressionnant sans transpirer.

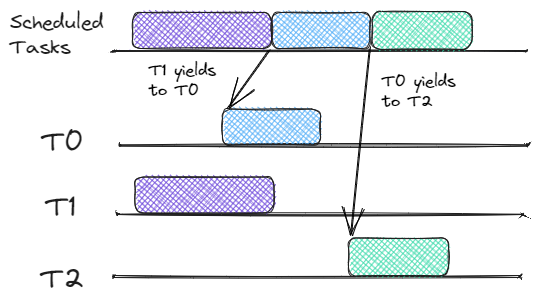

Conception de la File d'Attente : Une Vue d'Ensemble

Notre file d'attente de tâches se composera de trois éléments principaux :

- Récepteur de Tâches : Accepte les tâches entrantes et les pousse dans la file d'attente

- File d'Attente : Stocke les tâches en attente de traitement

- Processeur de Tâches : Tire les tâches de la file d'attente et les exécute

Voyons comment nous pouvons implémenter cela en utilisant les fonctionnalités asynchrones de Rust.

Le Récepteur de Tâches : Le Videur de Votre File d'Attente

Tout d'abord, créons une structure pour représenter nos tâches :

struct Job {

id: u64,

payload: String,

}

Maintenant, implémentons le récepteur de tâches :

use tokio::sync::mpsc;

async fn job_receiver(mut rx: mpsc::Receiver, queue: Arc>>) {

while let Some(job) = rx.recv().await {

let mut queue = queue.lock().await;

queue.push_back(job);

println!("Tâche reçue : {}", job.id);

}

}

Cette fonction utilise le canal MPSC (Multi-Producteur, Single-Consommateur) de Tokio pour recevoir les tâches et les pousser dans une file d'attente partagée.

La File d'Attente : Où les Tâches Attendent

Notre file d'attente est un simple VecDeque enveloppé dans un Arc> pour un accès concurrent sécurisé :

use std::collections::VecDeque;

use std::sync::Arc;

use tokio::sync::Mutex;

let queue: Arc>> = Arc::new(Mutex::new(VecDeque::new()));

Le Processeur de Tâches : Là où la Magie Opère

Maintenant, pour la pièce de résistance, notre processeur de tâches :

async fn job_processor(queue: Arc>>) {

loop {

let job = {

let mut queue = queue.lock().await;

queue.pop_front()

};

if let Some(job) = job {

println!("Traitement de la tâche : {}", job.id);

// Simuler un travail asynchrone

tokio::time::sleep(Duration::from_millis(100)).await;

println!("Tâche terminée : {}", job.id);

} else {

// Pas de tâches, faisons une petite pause

tokio::time::sleep(Duration::from_millis(10)).await;

}

}

}

Ce processeur fonctionne en boucle infinie, vérifiant les tâches et les traitant de manière asynchrone. S'il n'y a pas de tâches, il fait une courte pause pour éviter de tourner inutilement.

Tout Mettre Ensemble : L'Événement Principal

Maintenant, connectons tout cela dans notre fonction principale :

#[tokio::main]

async fn main() {

let (tx, rx) = mpsc::channel(100);

let queue = Arc::new(Mutex::new(VecDeque::new()));

// Lancer le récepteur de tâches

let queue_clone = Arc::clone(&queue);

tokio::spawn(async move {

job_receiver(rx, queue_clone).await;

});

// Lancer plusieurs processeurs de tâches

for _ in 0..4 {

let queue_clone = Arc::clone(&queue);

tokio::spawn(async move {

job_processor(queue_clone).await;

});

}

// Générer quelques tâches

for i in 0..1000 {

let job = Job {

id: i,

payload: format!("Tâche {}", i),

};

tx.send(job).await.unwrap();

}

// Attendre que toutes les tâches soient traitées

tokio::time::sleep(Duration::from_secs(10)).await;

}

Boosters de Performance : Conseils et Astuces

Maintenant que nous avons notre structure de base, voyons quelques moyens d'extraire encore plus de performance de notre file d'attente de tâches :

- Regroupement : Traiter plusieurs tâches dans une seule tâche asynchrone pour réduire la surcharge.

- Priorisation : Implémenter une file d'attente prioritaire au lieu d'un simple FIFO.

- Contre-pression : Utiliser des canaux limités pour éviter de surcharger le système.

- Métriques : Mettre en place un suivi pour surveiller la taille de la file d'attente, le temps de traitement et le débit.

Pièges Potentiels : Attention !

Comme pour tout système haute performance, il y a des choses à surveiller :

- Deadlocks : Faites attention à l'ordre des verrous lorsque vous utilisez plusieurs mutex.

- Épuisement des Ressources : Assurez-vous que votre système peut gérer le nombre maximal de tâches concurrentes.

- Gestion des Erreurs : Implémentez une gestion robuste des erreurs pour éviter que les échecs de tâches ne fassent planter tout le système.

Conclusion : Votre File d'Attente, Surboostée

En exploitant le runtime asynchrone de Rust, nous avons créé un backend de file d'attente de tâches capable de gérer un débit massif avec un minimum de surcharge. La combinaison de Tokio, des futures et des canaux nous permet de traiter les tâches de manière concurrente et efficace, en tirant le meilleur parti de nos ressources système.

Rappelez-vous, ce n'est qu'un point de départ. Vous pouvez encore optimiser et personnaliser ce système pour répondre à vos besoins spécifiques. Peut-être ajouter de la persistance, implémenter des tentatives pour les tâches échouées, ou même distribuer la file d'attente sur plusieurs nœuds. Les possibilités sont infinies !

"Avec un grand pouvoir vient une grande responsabilité" - Oncle Ben (et tous les programmeurs Rust)

Alors allez-y, exploitez la puissance du runtime asynchrone de Rust, et construisez des files d'attente de tâches qui feront ronronner même les systèmes les plus exigeants. Votre futur vous (et vos utilisateurs) vous remercieront !

Pistes de Réflexion

Avant de vous précipiter pour réécrire tout votre backend en Rust, prenez un moment pour réfléchir :

- Comment cela se comparerait-il à l'implémentation d'un système similaire en Go ou Node.js ?

- Quels types de charges de travail bénéficieraient le plus de cette architecture ?

- Comment géreriez-vous la persistance et la tolérance aux pannes dans un environnement de production ?

Bon codage, et que vos files d'attente soient toujours rapides et vos tâches toujours complètes !