Les Suspects Habituels

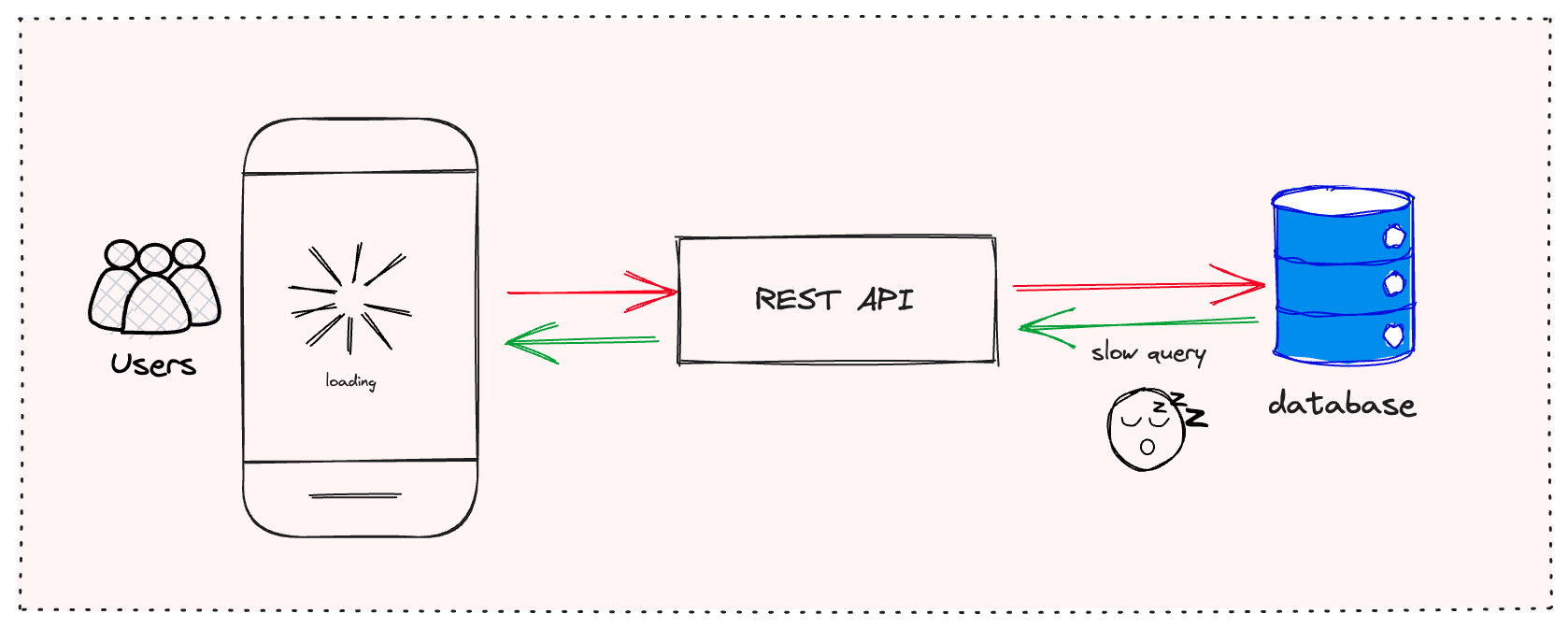

Avant de passer aux coupables sournois, passons rapidement en revue les suspects habituels que vous avez probablement déjà envisagés :

- Requêtes de base de données inefficaces

- Absence de mise en cache

- Configurations serveur non optimisées

- Latence réseau

Si vous avez déjà traité ces points et que vous constatez toujours des performances médiocres, il est temps d'examiner plus en profondeur. Dévoilons les méchants cachés qui se cachent dans l'ombre de votre API.

1. Le Ralentissement de la Sérialisation

Ah, la sérialisation. Le héros méconnu (ou le méchant) des performances API. Vous n'y pensez peut-être pas à deux fois, mais convertir vos objets en JSON et inversement peut être un goulot d'étranglement important, surtout avec de grandes charges utiles.

Le Problème :

De nombreuses bibliothèques de sérialisation populaires, bien que pratiques, ne sont pas optimisées pour la vitesse. Elles utilisent souvent la réflexion, qui peut être lente, surtout dans des langages comme Java.

La Solution :

Envisagez d'utiliser des bibliothèques de sérialisation plus rapides. Pour Java, par exemple, Jackson avec le module afterburner ou DSL-JSON peut considérablement accélérer les choses. Voici un exemple rapide utilisant le module afterburner de Jackson :

ObjectMapper mapper = new ObjectMapper();

mapper.registerModule(new AfterburnerModule());

// Utilisez maintenant ce mapper pour la sérialisation/désérialisation

String json = mapper.writeValueAsString(myObject);

MyObject obj = mapper.readValue(json, MyObject.class);

N'oubliez pas, chaque milliseconde compte lorsque vous traitez des milliers de requêtes !

2. Le Validateur Trop Zélé

La validation des entrées est cruciale, mais en faites-vous trop ? Une validation trop complexe peut devenir un cauchemar de performance plus vite que vous ne pouvez dire "400 Bad Request".

Le Problème :

Valider chaque champ avec des règles complexes, surtout pour de grands objets, peut considérablement ralentir votre API. De plus, si vous utilisez un framework de validation lourd, vous pourriez subir un surcoût inutile.

La Solution :

Trouvez un équilibre. Validez les champs critiques côté serveur, mais envisagez de déléguer une partie de la validation au client. Utilisez des bibliothèques de validation légères et envisagez de mettre en cache les résultats de validation pour les données fréquemment consultées.

Par exemple, si vous utilisez la validation des beans de Java, vous pouvez mettre en cache l'instance Validator :

private static final Validator validator;

static {

ValidatorFactory factory = Validation.buildDefaultValidatorFactory();

validator = factory.getValidator();

}

// Utilisez cette instance de validateur dans toute votre application

3. L'Avalanche d'Authentification

La sécurité est non négociable, mais une authentification mal implémentée peut transformer votre API en un véritable cauchemar de lenteur.

Le Problème :

Authentifier chaque requête en accédant à la base de données ou à un service d'authentification externe peut introduire une latence significative, surtout sous forte charge.

La Solution :

Mettez en œuvre une authentification basée sur des jetons avec mise en cache. Les JSON Web Tokens (JWT) sont une excellente option. Ils vous permettent de vérifier la signature du jeton sans accéder à la base de données à chaque requête.

Voici un exemple simple utilisant la bibliothèque jjwt en Java :

String jwtToken = Jwts.builder()

.setSubject(username)

.signWith(SignatureAlgorithm.HS256, secretKey)

.compact();

// Plus tard, pour vérifier :

Jws claims = Jwts.parser()

.setSigningKey(secretKey)

.parseClaimsJws(jwtToken);

String username = claims.getBody().getSubject();

4. Le Syndrome de l'API Bavarde

Votre API est-elle plus bavarde qu'un animateur de podcast ? Les requêtes HTTP excessives peuvent être un tueur de performance majeur.

Le Problème :

Les APIs qui nécessitent plusieurs allers-retours pour compléter une seule opération logique peuvent souffrir d'une latence accrue et d'un débit réduit.

La Solution :

Adoptez le regroupement et les opérations en masse. Au lieu de faire des appels séparés pour chaque élément, permettez aux clients d'envoyer plusieurs éléments dans une seule requête. GraphQL peut également être un atout ici, permettant aux clients de demander exactement ce dont ils ont besoin en une seule requête.

Si vous utilisez Spring Boot, vous pouvez facilement implémenter un point de terminaison de lot :

@PostMapping("/users/batch")

public List createUsers(@RequestBody List users) {

return userService.createUsers(users);

}

5. La Réponse Encombrée

Vos réponses API transportent-elles plus de poids qu'un lutteur de sumo ? Des réponses trop verbeuses peuvent ralentir votre API et augmenter l'utilisation de la bande passante.

Le Problème :

Retourner plus de données que nécessaire, y compris des champs non utilisés par le client, peut considérablement augmenter la taille de la réponse et le temps de traitement.

La Solution :

Mettez en œuvre le filtrage des réponses et la pagination. Permettez aux clients de spécifier les champs qu'ils souhaitent recevoir. Pour les collections, utilisez toujours la pagination pour limiter la quantité de données envoyées dans une seule réponse.

Voici un exemple de la façon dont vous pourriez implémenter le filtrage des champs dans Spring Boot :

@GetMapping("/users")

public List getUsers(@RequestParam(required = false) String fields) {

List users = userService.getAllUsers();

if (fields != null) {

ObjectMapper mapper = new ObjectMapper();

SimpleFilterProvider filterProvider = new SimpleFilterProvider();

filterProvider.addFilter("userFilter", SimpleBeanPropertyFilter.filterOutAllExcept(fields.split(",")));

mapper.setFilterProvider(filterProvider);

return mapper.convertValue(users, new TypeReference>() {});

}

return users;

}

6. La Lamentation du Chargement Impatient

Récupérez-vous des données comme si vous vous prépariez à une apocalypse des données ? Un chargement de données trop zélé peut être un tueur de performance silencieux.

Le Problème :

Charger toutes les entités liées pour un objet, même lorsqu'elles ne sont pas nécessaires, peut entraîner des requêtes de base de données inutiles et des temps de réponse accrus.

La Solution :

Mettez en œuvre le chargement paresseux et utilisez des projections. Récupérez uniquement les données dont vous avez besoin quand vous en avez besoin. De nombreux ORM prennent en charge le chargement paresseux par défaut, mais vous devez l'utiliser judicieusement.

Si vous utilisez Spring Data JPA, vous pouvez créer des projections pour récupérer uniquement les champs requis :

public interface UserSummary {

Long getId();

String getName();

String getEmail();

}

@Repository

public interface UserRepository extends JpaRepository {

List findAllProjectedBy();

}

7. La Stratégie de Mise en Cache Inconsciente

Vous avez mis en œuvre la mise en cache, félicitations ! Mais attendez, mettez-vous en cache intelligemment ou cachez-vous tout ce qui vous tombe sous la main ?

Le Problème :

La mise en cache sans stratégie appropriée peut entraîner des données obsolètes, une utilisation inutile de la mémoire et même des performances plus lentes si elle n'est pas effectuée correctement.

La Solution :

Mettez en œuvre une stratégie de mise en cache intelligente. Mettez en cache les données fréquemment consultées et rarement modifiées. Utilisez des politiques d'éviction de cache et envisagez d'utiliser un cache distribué pour l'évolutivité.

Voici un exemple utilisant l'abstraction de mise en cache de Spring :

@Cacheable(value = "users", key = "#id", unless = "#result == null")

public User getUserById(Long id) {

return userRepository.findById(id).orElse(null);

}

@CacheEvict(value = "users", key = "#user.id")

public void updateUser(User user) {

userRepository.save(user);

}

À Retenir

L'optimisation des performances est un processus continu, pas une tâche ponctuelle. Ces tueurs cachés peuvent s'infiltrer dans votre API au fil du temps, il est donc crucial de profiler et de surveiller régulièrement les performances de votre API.

Rappelez-vous, le code le plus rapide est souvent celui qui ne s'exécute pas du tout. Demandez-vous toujours si vous devez effectuer une opération, récupérer une donnée ou inclure un champ dans votre réponse.

En traitant ces tueurs de performance cachés, vous pouvez transformer votre API lente en une machine de traitement de requêtes rapide et efficace. Vos utilisateurs (et votre équipe d'exploitation) vous en remercieront !

"L'optimisation prématurée est la racine de tout mal." - Donald Knuth

Mais en ce qui concerne les APIs, une optimisation opportune est la clé du succès. Alors allez-y, profilez votre API, et que vos temps de réponse soient toujours en votre faveur !

Réflexions

Avant de vous précipiter pour optimiser votre API, prenez un moment pour réfléchir :

- Mesurez-vous les bons indicateurs ? Le temps de réponse est important, mais considérez également le débit, les taux d'erreur et l'utilisation des ressources.

- Avez-vous envisagé les compromis ? Parfois, optimiser pour la vitesse peut se faire au détriment de la lisibilité ou de la maintenabilité. Cela en vaut-il la peine ?

- Optimisez-vous pour les bons cas d'utilisation ? Assurez-vous de vous concentrer sur les points de terminaison et les opérations qui comptent le plus pour vos utilisateurs.

Rappelez-vous, le but n'est pas seulement d'avoir une API rapide, mais d'avoir une API qui fournit de la valeur à vos utilisateurs de manière efficace et fiable. Maintenant, faites en sorte que votre API soit rapide !