Le scaling horizontal nous permet de :

- Gérer d'énormes afflux de données sans transpirer

- Distribuer la charge de traitement sur plusieurs nœuds

- Améliorer la tolérance aux pannes (parce que qui n'aime pas un bon basculement ?)

- Maintenir une faible latence même lorsque les volumes de données explosent

Mais voici le hic : faire évoluer Kafka Streams horizontalement n'est pas aussi simple que de lancer plus d'instances et de s'en contenter. Oh non, mes amis. C'est plutôt comme ouvrir la boîte de Pandore des défis des systèmes distribués.

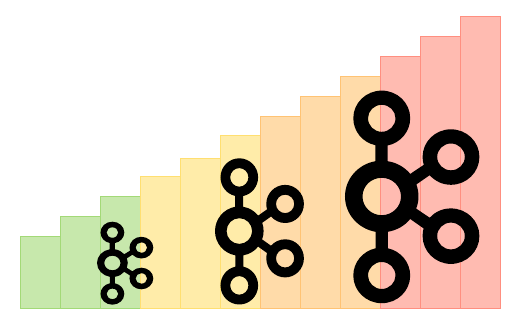

L'Anatomie du Scaling de Kafka Streams

Avant de plonger dans les problèmes, jetons un coup d'œil rapide à la façon dont Kafka Streams évolue réellement. Ce n'est pas magique (malheureusement), mais c'est assez astucieux :

- Kafka Streams divise votre topologie en tâches

- Chaque tâche traite une ou plusieurs partitions de vos sujets d'entrée

- Lorsque vous ajoutez plus d'instances, Kafka Streams redistribue ces tâches

Ça a l'air simple, non ? Eh bien, accrochez-vous à vos tasses de café, car c'est là que les choses commencent à devenir intéressantes (et par intéressantes, je veux dire potentiellement frustrantes).

La Lutte avec l'État

L'un des plus grands défis dans le scaling de Kafka Streams vient de la gestion des opérations avec état. Vous savez, ces agrégations et jointures embêtantes qui rendent nos vies à la fois plus faciles et plus difficiles.

Le problème ? L'état. Il est partout, et il n'aime pas bouger.

"L'état est comme cet ami qui reste toujours trop longtemps aux fêtes. C'est utile de l'avoir, mais ça rend le départ (ou dans notre cas, le scaling) vraiment pénible."

Lorsque vous évoluez, Kafka Streams doit déplacer l'état. Cela conduit à quelques situations délicates :

- Des baisses de performance temporaires pendant la migration de l'état

- Des incohérences de données potentielles si elles ne sont pas gérées correctement

- Une augmentation du trafic réseau à mesure que l'état est déplacé

Pour atténuer ces problèmes, vous voudrez prêter une attention particulière à votre configuration RocksDB. Voici un extrait pour vous aider à démarrer :

Properties props = new Properties();

props.put(StreamsConfig.ROCKSDB_CONFIG_SETTER_CLASS_CONFIG, CustomRocksDBConfig.class);

Et dans votre classe CustomRocksDBConfig :

public class CustomRocksDBConfig implements RocksDBConfigSetter {

@Override

public void setConfig(final String storeName, final Options options, final Map configs) {

BlockBasedTableConfig tableConfig = new BlockBasedTableConfig();

tableConfig.setBlockCacheSize(50 * 1024 * 1024L);

tableConfig.setBlockSize(4096L);

options.setTableFormatConfig(tableConfig);

options.setMaxWriteBufferNumber(3);

}

}

Cette configuration peut aider à réduire l'impact de la migration de l'état en optimisant la gestion des données par RocksDB. Mais rappelez-vous, il n'y a pas de solution universelle ici. Vous devrez ajuster en fonction de votre cas d'utilisation spécifique.

L'Acte de Rééquilibrage

Ajouter de nouvelles instances à votre application Kafka Streams déclenche un rééquilibrage. En théorie, c'est génial – c'est ainsi que nous distribuons la charge. En pratique, c'est comme essayer de réorganiser votre placard tout en vous habillant pour une fête.

Lors d'un rééquilibrage :

- Le traitement s'arrête (espérons que vous n'aviez pas besoin de ces données tout de suite !)

- L'état doit être migré (voir notre point précédent sur les luttes avec état)

- Votre système peut connaître une latence temporairement plus élevée

Pour minimiser la douleur du rééquilibrage, envisagez les éléments suivants :

- Utilisez le partitionnement collant pour réduire les mouvements de partition inutiles

- Implémentez un assignateur de partition personnalisé pour plus de contrôle

- Ajustez votre

max.poll.interval.mspour permettre des temps de traitement plus longs pendant les rééquilibrages

Voici comment vous pourriez configurer le partitionnement collant dans votre application Quarkus :

quarkus.kafka-streams.partition.assignment.strategy=org.apache.kafka.streams.processor.internals.StreamsPartitionAssignor

Le Paradoxe de la Performance

Voici un fait amusant : parfois, ajouter plus d'instances peut en fait réduire vos performances globales. Je sais, ça ressemble à une mauvaise blague, mais c'est bien réel.

Les coupables ?

- Augmentation du trafic réseau

- Rééquilibrages plus fréquents

- Plus de surcharge de coordination

Pour lutter contre cela, vous devez être stratégique sur la façon dont vous évoluez. Quelques conseils :

- Surveillez de près votre débit et votre latence

- Évoluez par petits incréments

- Optimisez votre stratégie de partitionnement des sujets

En parlant de surveillance, voici un exemple rapide de la façon dont vous pourriez configurer des métriques de base dans votre application Quarkus :

@Produces

@ApplicationScoped

public KafkaStreams kafkaStreams(KafkaStreamsBuilder builder) {

Properties props = new Properties();

props.put(StreamsConfig.METRICS_RECORDING_LEVEL_CONFIG, Sensor.RecordingLevel.DEBUG.name());

return builder.withProperties(props).build();

}

Cela vous donnera des métriques plus détaillées pour travailler, vous aidant à identifier les goulots d'étranglement de performance à mesure que vous évoluez.

Le Casse-tête de la Cohérence des Données

À mesure que nous évoluons, maintenir la cohérence des données devient plus délicat. Rappelez-vous, Kafka Streams garantit l'ordre de traitement au sein d'une partition, mais lorsque vous jonglez avec plusieurs instances et rééquilibrages, les choses peuvent devenir compliquées.

Les principaux défis incluent :

- Assurer des sémantiques exactement-une-fois entre les instances

- Gérer les événements hors ordre pendant les rééquilibrages

- Gérer les fenêtres temporelles à travers les magasins d'état distribués

Pour relever ces défis :

- Utilisez la garantie de traitement exactement-une-fois (mais soyez conscient du compromis de performance)

- Implémentez une gestion des erreurs et des mécanismes de réessai appropriés

- Envisagez d'utiliser un

TimestampExtractorpersonnalisé pour un meilleur contrôle sur le temps des événements

Voici comment vous pourriez configurer des sémantiques exactement-une-fois dans votre application Quarkus :

quarkus.kafka-streams.processing.guarantee=exactly_once

Mais rappelez-vous, avec un grand pouvoir vient une grande responsabilité (et potentiellement une latence accrue).

Le Casse-tête de la Gestion des Erreurs

Lorsque vous traitez avec des systèmes distribués, les erreurs ne sont pas seulement possibles – elles sont inévitables. Et dans une application Kafka Streams évoluée, la gestion des erreurs devient encore plus critique.

Les scénarios d'erreur courants incluent :

- Des partitions réseau causant la désynchronisation des instances

- Des erreurs de désérialisation dues à des changements de schéma

- Des exceptions de traitement qui pourraient potentiellement empoisonner tout le flux

Pour construire un système plus résilient :

- Implémentez une gestion des erreurs robuste dans vos processeurs de flux

- Utilisez des files d'attente de lettres mortes (DLQ) pour les messages qui échouent au traitement

- Mettez en place une surveillance et des alertes appropriées pour une détection rapide des problèmes

Voici un exemple simple de la façon dont vous pourriez implémenter une DLQ dans votre topologie Kafka Streams :

builder.stream("input-topic")

.mapValues((key, value) -> {

try {

return processValue(value);

} catch (Exception e) {

// Envoyer à la DLQ

producer.send(new ProducerRecord<>("dlq-topic", key, value));

return null;

}

})

.filter((key, value) -> value != null)

.to("output-topic");

De cette façon, tous les messages qui échouent au traitement sont envoyés à une DLQ pour une inspection ultérieure et un éventuel retraitement.

Les Particularités de Quarkus

Maintenant, vous pourriez penser, "D'accord, mais comment Quarkus s'intègre-t-il dans tout cela ?" Eh bien, mon ami, Quarkus apporte sa propre saveur à la fête du scaling de Kafka Streams.

Quelques considérations spécifiques à Quarkus :

- Exploiter les temps de démarrage rapides de Quarkus pour un scaling plus rapide

- Utiliser les options de configuration de Quarkus pour affiner Kafka Streams

- Profiter de la compilation native de Quarkus pour améliorer les performances

Voici une astuce sympa : vous pouvez utiliser les propriétés de configuration de Quarkus pour ajuster dynamiquement votre configuration Kafka Streams en fonction de l'environnement. Par exemple :

%dev.quarkus.kafka-streams.bootstrap-servers=localhost:9092

%prod.quarkus.kafka-streams.bootstrap-servers=${KAFKA_BOOTSTRAP_SERVERS}

quarkus.kafka-streams.application-id=${KAFKA_APPLICATION_ID:my-streams-app}

Cela vous permet de passer facilement des configurations de développement à celles de production, rendant votre vie un peu plus facile à mesure que vous évoluez.

En Conclusion : La Saga du Scaling Continue

Faire évoluer Kafka Streams horizontalement dans Quarkus n'est pas une promenade de santé. C'est plutôt comme une randonnée à travers une jungle dense remplie de sables mouvants avec état, de lianes de rééquilibrage et de prédateurs mangeurs de performance. Mais armé des bonnes connaissances et outils, vous pouvez naviguer dans ce terrain et construire des applications de traitement de flux véritablement évolutives et résilientes.

Rappelez-vous :

- Surveillez, surveillez, surveillez – vous ne pouvez pas réparer ce que vous ne pouvez pas voir

- Testez vos stratégies de scaling minutieusement avant de passer en production

- Soyez prêt à itérer et à affiner votre configuration

- Embrassez les défis – ce sont eux qui nous rendent meilleurs ingénieurs (ou du moins, c'est ce que je me dis)

Alors que vous vous lancez dans votre voyage de scaling de Kafka Streams, gardez ce guide à portée de main. Et rappelez-vous, en cas de doute, ajoutez plus d'instances ! (Je plaisante, ne faites pas ça sans une planification appropriée.)

Bon streaming, et que vos partitions soient toujours parfaitement équilibrées !