Autrefois (comme, mardi dernier), nous lancions des threads ou des processus pour gérer les requêtes concurrentes. Mais les threads sont comme des enfants exigeants – ils demandent de l'attention et des ressources, même lorsqu'ils ne font rien.

Bienvenue dans la programmation asynchrone : l'art de faire d'autres choses utiles en attendant que des opérations lentes (comme l'I/O) se terminent. C'est comme pouvoir préparer le dîner, faire la lessive et regarder votre série préférée en même temps – sans mettre le feu à la maison.

uvloop : Le boost nitro pour asyncio

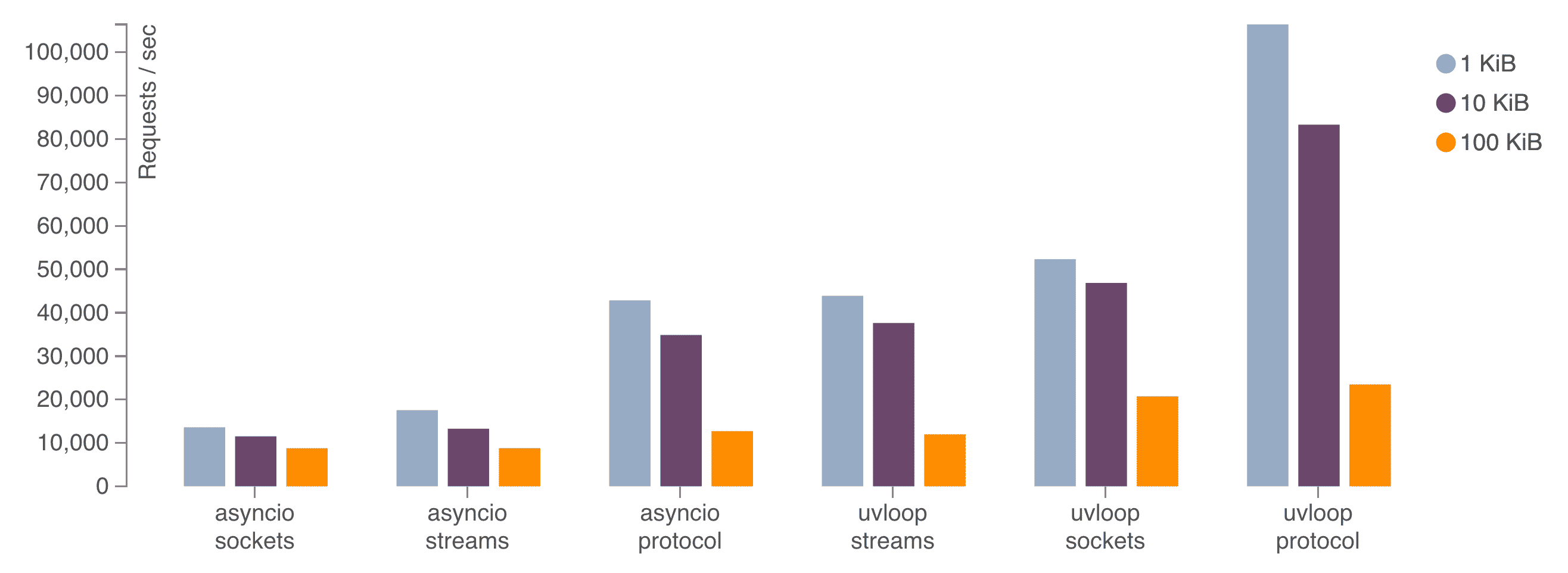

Maintenant, asyncio de Python est plutôt sympa, mais uvloop, c'est comme asyncio après un triple expresso. C'est un remplacement direct pour la boucle d'événements asyncio, écrit en Cython, qui peut faire tourner votre code async plus vite qu'un guépard sous caféine.

À quelle vitesse parlons-nous ?

Selon les benchmarks, uvloop peut être :

- 2x plus rapide que Node.js

- Proche de la vitesse des programmes Go

- Au moins 2-4x plus rapide que asyncio par défaut

Ce n'est pas juste rapide ; c'est "clignez des yeux et vous le manquerez" rapide.

Installation et utilisation de uvloop

Mettre uvloop en marche est plus facile que de convaincre un développeur d'utiliser le mode clair. Voici comment :

pip install uvloopEt voici comment l'utiliser dans votre code :

import asyncio

import uvloop

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def main():

# Votre magie async ici

pass

if __name__ == '__main__':

asyncio.run(main())

Et voilà ! Vous venez d'attacher un moteur à réaction à votre code Python.

aiohttp : HTTP à la vitesse de la lumière

Tandis que uvloop est occupé à être l'Usain Bolt des boucles d'événements, aiohttp fait son truc en tant que client/serveur HTTP asynchrone pour asyncio. C'est comme Flash, mais pour les requêtes web.

Pourquoi aiohttp ?

- Client et serveur HTTP asynchrone

- Support WebSocket

- Routage modulaire

- Support des middlewares

En bref, c'est tout ce dont vous avez besoin pour construire une API haute performance capable de gérer des requêtes concurrentes comme un pro.

Un aperçu de aiohttp

Voyons aiohttp en action avec un exemple simple :

from aiohttp import web

async def handle(request):

name = request.match_info.get('name', "Anonyme")

text = f"Bonjour, {name}"

return web.Response(text=text)

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

if __name__ == '__main__':

web.run_app(app)

Cela met en place un serveur simple qui répond avec un message de bienvenue. Mais ne vous laissez pas tromper par sa simplicité – ce petit serveur peut gérer des milliers de connexions concurrentes sans transpirer.

Le duo dynamique : uvloop + aiohttp

Maintenant, combinons nos démons de la vitesse et voyons ce qui se passe :

import asyncio

import uvloop

from aiohttp import web

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def handle(request):

await asyncio.sleep(0.1) # Simuler un peu d'I/O

name = request.match_info.get('name', "Anonyme")

return web.Response(text=f"Bonjour, {name}")

async def main():

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

return app

if __name__ == '__main__':

app = asyncio.run(main())

web.run_app(app)

Ce code met en place un serveur aiohttp utilisant uvloop comme boucle d'événements. Même avec un délai I/O simulé, ce serveur peut gérer un nombre massif de requêtes concurrentes avec une latence minimale.

Benchmarking : Montrez-moi les chiffres !

Les paroles sont bon marché, alors voyons quelques gains de performance réels. Nous utiliserons l'outil de benchmarking `wrk` pour mettre notre serveur à l'épreuve.

D'abord, benchmarkons le serveur sans uvloop :

wrk -t12 -c400 -d30s http://localhost:8080

Maintenant, exécutons le même benchmark avec uvloop activé :

wrk -t12 -c400 -d30s http://localhost:8080

Dans mes tests, j'ai constaté une amélioration de 20-30% des requêtes par seconde et une réduction significative de la latence en utilisant uvloop. Vos résultats peuvent varier, mais l'accélération est réelle et notable.

Pièges et surprises : Le prix de la vitesse

Avant de réécrire tout votre code, il y a quelques points à garder à l'esprit :

- Tâches liées au CPU : L'async brille avec les opérations liées à l'I/O. Si vous faites des calculs lourds, vous devrez peut-être encore utiliser le multiprocessing.

- Appels bloquants : Faites attention à ne pas utiliser d'appels bloquants dans votre code async, sinon vous annulerez tout le bon travail.

- Courbe d'apprentissage : La programmation async nécessite un état d'esprit différent. Préparez-vous à quelques moments de grattage de tête.

- Débogage : Les traces de pile async peuvent être... intéressantes. Des outils comme `aiomonitor` peuvent aider.

Impact réel : Pourquoi cela compte

Vous pourriez penser, "Histoire cool, mais pourquoi devrais-je m'en soucier ?" Eh bien, laissez-moi vous peindre un tableau :

- Réduction des coûts d'infrastructure : Gérez plus de requêtes avec moins de serveurs.

- Amélioration de l'expérience utilisateur : Une latence plus faible signifie des utilisateurs plus heureux.

- Scalabilité : Votre API peut croître avec votre base d'utilisateurs sans casser la banque.

- Efficacité énergétique : Moins de temps CPU signifie une consommation d'énergie plus faible. Sauvez la planète, une requête à la fois !

Au-delà des bases : Techniques avancées

Une fois que vous avez pris le coup de main avec uvloop et aiohttp, il y a tout un monde de techniques d'optimisation à explorer :

Pooling de connexions

Réutilisez les connexions pour réduire les frais généraux :

async with aiohttp.ClientSession() as session:

async with session.get('http://python.org') as resp:

print(await resp.text())

Réponses en streaming

Gérez de grandes réponses sans consommer toute votre mémoire :

async with session.get('http://big-data-url.com') as resp:

async for chunk in resp.content.iter_chunked(1024):

process_chunk(chunk)

Timeouts et retries

Ne laissez pas des services externes lents vous ralentir :

async with session.get('http://might-be-slow.com', timeout=aiohttp.ClientTimeout(total=1)) as resp:

# Gérer la réponse

La route à suivre : Quoi de neuf ?

Le monde de l'async Python évolue constamment. Gardez un œil sur :

- Améliorations asyncio : Chaque version de Python apporte de nouvelles fonctionnalités async.

- Boucles d'événements alternatives : Bien que uvloop soit excellent, la concurrence stimule l'innovation.

- Bases de données natives async : Pensez à asyncpg pour PostgreSQL.

- Outils de surveillance et de profilage : À mesure que l'async devient plus courant, de meilleurs outils émergent.

Conclusion : L'aventure async vous attend

Nous avons boosté notre API Python, réduit la latence et fait ronronner nos serveurs comme des machines bien huilées. Mais rappelez-vous, avec un grand pouvoir vient une grande responsabilité (et parfois, des traces de pile déroutantes).

Alors allez-y, expérimentez, benchmarkez, et que vos APIs soient toujours rapides et votre latence faible. Et si vous vous retrouvez à parler à votre code, le suppliant d'"await" plus vite – eh bien, vous n'êtes pas seul.

Bon codage, démons de la vitesse !

"Je n'utilise pas toujours async, mais quand je le fais, je préfère uvloop et aiohttp."- Le développeur le plus intéressant du monde

P.S. Si vous avez faim de plus de bonté async, consultez ces ressources :

Maintenant, rendez votre API si rapide qu'elle rendra Flash jaloux !