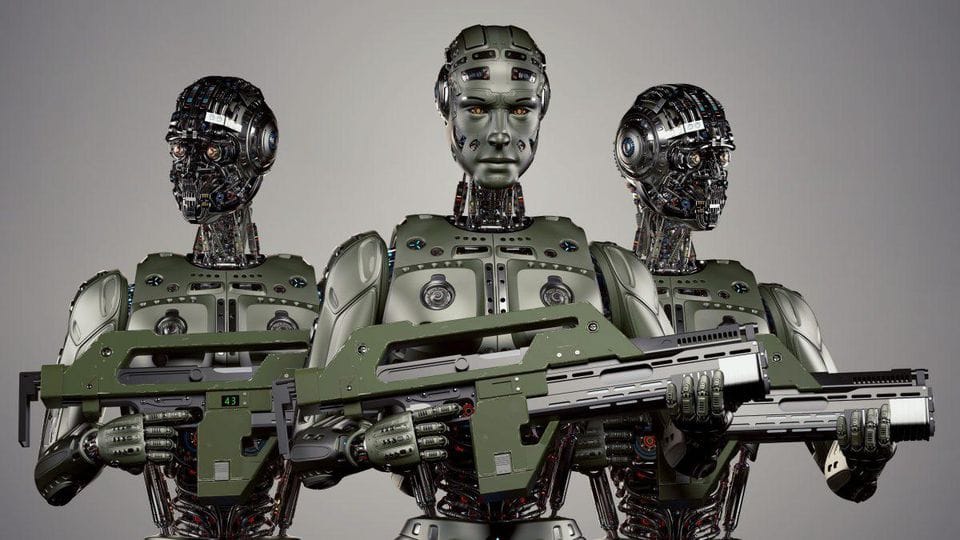

Les systèmes d'armes autonomes sont des plateformes militaires capables de sélectionner et d'engager des cibles sans intervention humaine. Pensez à eux comme aux cousins mortels des voitures autonomes. Au lieu de naviguer dans le trafic, ils naviguent sur les champs de bataille. Et au lieu d'éviter les collisions, ils... vous voyez l'idée.

Ces systèmes peuvent aller de :

- Drones autonomes capables d'identifier et d'attaquer des positions ennemies

- Systèmes de missiles alimentés par l'IA qui peuvent ajuster leur trajectoire en vol

- Sentinelles robotiques qui gardent les frontières ou des installations sensibles

La caractéristique clé ici est l'autonomie. Contrairement aux armes télécommandées, les AWS prennent leurs propres décisions basées sur des paramètres préprogrammés et une analyse de données en temps réel.

Le Champ de Mines Éthique

Maintenant que nous avons compris les bases, plongeons dans le marécage éthique. Le développement et le déploiement des AWS soulèvent une série de questions morales qui feraient réfléchir même le philosophe le plus aguerri.

1. Le Fossé de Responsabilité

Qui est responsable lorsqu'une arme autonome commet une erreur ? Le programmeur qui a écrit l'algorithme ? Le commandant militaire qui l'a déployée ? L'IA elle-même ? Ce "fossé de responsabilité" est un obstacle majeur dans le débat éthique.

"Un grand pouvoir implique de grandes responsabilités" - Oncle Ben, Spider-Man

Mais que se passe-t-il lorsque ce pouvoir est exercé par une IA qui ne comprend pas le concept de responsabilité ?

2. Le Seuil Abaissé pour les Conflits Armés

Si les guerres peuvent être menées avec des robots au lieu de soldats humains, cela rend-il l'action militaire plus acceptable ? Il y a une inquiétude que les AWS pourraient abaisser le seuil des conflits armés, rendant la guerre plus fréquente.

3. Manque de Jugement Humain

Les humains peuvent prendre en compte le contexte, les nuances et les changements de dernière minute qui pourraient affecter une décision d'utiliser la force létale. Pouvons-nous vraiment faire confiance à une IA pour prendre ces décisions de vie ou de mort ?

4. Potentiel d'Abus

Entre de mauvaises mains, les AWS pourraient être utilisées pour l'oppression, le terrorisme ou d'autres fins néfastes. La démocratisation de la technologie militaire avancée est une épée à double tranchant.

Paysage Réglementaire Actuel

Alors, l'IA peut-elle être réglementée dans la guerre ? La réponse courte est : nous essayons, mais c'est compliqué.

Actuellement, il n'existe pas de traité international régissant spécifiquement les AWS. Cependant, plusieurs initiatives sont en cours :

- La Convention sur certaines armes classiques (CCW) discute des AWS depuis 2014

- La Campagne pour arrêter les robots tueurs pousse pour une interdiction préventive des armes entièrement autonomes

- Certains pays, comme la Belgique et le Luxembourg, ont déjà interdit les AWS dans leurs doctrines militaires

Le défi réside dans la création de réglementations suffisamment spécifiques pour être efficaces, mais suffisamment flexibles pour tenir compte des avancées technologiques rapides.

Approches Réglementaires Potentielles

Explorons quelques moyens potentiels de réglementer l'IA dans la guerre :

1. Traité International

Un traité international complet pourrait établir des lignes directrices claires pour le développement et l'utilisation des AWS. Cela pourrait inclure :

- Définitions de ce qui constitue une arme autonome

- Règles d'engagement pour les AWS

- Mécanismes de responsabilité lorsque les choses tournent mal

2. Exigence de "L'Humain dans la Boucle"

Imposer une supervision humaine dans toutes les opérations des AWS pourrait aider à répondre à certaines préoccupations éthiques. Cela pourrait être mis en œuvre à divers niveaux :

def autonomous_weapon_system(target):

if human_approval():

engage_target(target)

else:

stand_down()

def human_approval():

# Cette fonction nécessiterait qu'un opérateur humain approuve l'action

return input("Approuver l'engagement de la cible ? (o/n) : ") == 'o'

3. Conception Éthique de l'IA

Incorporer des considérations éthiques dans le tissu même des systèmes d'IA pourrait aider à atténuer certains risques. Cela pourrait impliquer :

- Programmer les lois de la guerre et les règles d'engagement

- Mettre en œuvre des mécanismes de sécurité et d'abandon robustes

- Concevoir des systèmes avec transparence et auditabilité à l'esprit

4. Organe International de Surveillance

Un organisme international indépendant pourrait être établi pour surveiller le développement et le déploiement des AWS, similaire au rôle de l'Agence internationale de l'énergie atomique dans la non-prolifération nucléaire.

La Route à Suivre

Réglementer l'IA dans la guerre est une tâche herculéenne, mais c'est une tâche que nous ne pouvons pas nous permettre d'ignorer. Alors que la technologie continue de progresser à une vitesse vertigineuse, nos cadres éthiques et réglementaires doivent suivre le rythme.

Voici quelques considérations clés pour l'avenir :

- Collaboration interdisciplinaire : Nous avons besoin que des éthiciens, des technologues, des décideurs politiques et des experts militaires travaillent ensemble pour élaborer des réglementations efficaces.

- Transparence : Les pays développant des AWS devraient être transparents quant à leurs capacités et intentions.

- Dialogue continu : À mesure que la technologie évolue, notre approche de sa réglementation doit également évoluer. Des discussions internationales régulières sont cruciales.

- Sensibilisation du public : Les implications des AWS ne devraient pas être une préoccupation uniquement pour les experts. La compréhension et la contribution du public sont vitales.

Réflexions

Alors que nous concluons cette plongée approfondie dans l'éthique des armes autonomes, voici quelques questions à méditer :

- Est-il possible de créer un système d'IA capable de prendre des décisions éthiques en matière de guerre mieux que les humains ?

- Comment équilibrer les avantages potentiels des AWS (comme la réduction des pertes humaines) avec les risques éthiques ?

- Le développement des AWS pourrait-il conduire à une course aux armements IA ? Si oui, comment l'empêcher ?

Le débat autour des systèmes d'armes autonomes est loin d'être terminé. En tant que technologues, il est crucial que nous nous engagions dans ces questions éthiques. Après tout, le code que nous écrivons aujourd'hui pourrait façonner les champs de bataille de demain.

"Le vrai problème n'est pas de savoir si les machines pensent, mais si les hommes le font." - B.F. Skinner

Assurons-nous de réfléchir profondément aux implications de notre travail. L'avenir de la guerre - et potentiellement de l'humanité elle-même - pourrait en dépendre.